Niedawno znów wysłałem e-mail do pewnej grupy osób, które znam i wiem, że zajmują się SEO. Tym razem poprosiłem o przygotowanie wypowiedzi na temat ulepszania profilu linków poprzez rezygnację lub likwidację linków słabej jakości (cokolwiek znaczy „słaba jakość” :).

Tym razem wypowiedzi oscylowały głównie wokół zrzekania się linków i metod wyszukania linków, które są do odstrzału. Kilka z wypowiedzi zawiera także ilustracje z narzędzi jakie można w tym procesie stosować. Skumulowana lista narzędzi wspomnianych w wypowiedziach znajduje się pod całym artykułem.

Raz jeszcze Dzięki uprzejmości naczelnego seografika Dawida Tkocza, autora logo SEO Poland, mogę opatrzyć ten zbiór rad właśnie tą grafiką.

Sławomir Chojnacki / Bizzit

Co to jest link słabej jakości?

Co to jest link słabej jakości?

Link „słabej jakości” to NIE jest link ze słabej witryny, z SWL-a, ze strony spamerskiej itd.…

otóż taki link po prostu jest „słaby” (nie wpłynie na PageRank pozycjonowanych fraz w SERP-ach), ALE nie oznacza jeszcze tego, że zaszkodził naszej witrynie!

Link „Słabej jakości” to taki, dla którego przynajmniej 3 z 4 poniższych twierdzeń jest prawdziwych:

- Anchor (lub atrybut ALT) linku jest dopasowany zbyt mocno do linkowanej strony lub strony głównej

- Zbyt duży procent pozostałych linków prowadzących do serwisu jest podobnych anchorem z analizowanym właśnie linkiem

- Lokalizacji na której jest link jest inny tematycznie niż anchor linku

- Link pochodzi z serwisu, dla którego narzędzia analityczne, statystki oraz wskaźniki serwisu mówią nam że serwis, który do nas linkuje jest słaby (np. słaby MozRank, Google site, PR, alexa.. i cokolwiek innego czym się sugerujecie.. ;-))

…jeżeli przynajmniej 3 powyższe zdania są prawdziwe dla rozpatrywanego linku, oznacza to że link trzeba usunąć!

Kombinacji jest dużo! dokładnie: 16 (cztery pytania TAK/NIE), a 5 z tych kombinacji sugeruje aby link usunąć.

Każda kombinacja z tych 16 znajduje przykłady w praktyce, i da się sensownie uzasadnić.

Narzędzie do analityki powyższych punktów:

- wszelkie dostępne „informatory” back linków (MajesticSEO, Ahrefs, GWT itd., czyli wszystko co uczyni listę BL bardzo dokładną)

- SEO SpyGlass aby sprawdzić szczegółowe dane linku (domeny, serwisu, title, anchor, nofollow.. i wiele innych)

- i na końcu już narzędzie autorskie, które sugeruje nam na podstawie powyższych punktów, które linki usunąć

- know-how to odpowiednie ustawienie ostatniego narzędzia dla: „dopasowanie przybliżone” i „dopasowanie do wyrażenia” znane z Google AdWords, przy porównywaniu naszych title-anchorów pkt. 1-3 => czyli już bardziej intuicja i doświadczenie jakie wagi przypisać Waszej „automatycznej pomagające” aby uzyskać sensowne wyniki 🙂

Piotr Cichosz / Shpyo

W przypadku powiadomienia o nienaturalnych linkach najważniejsze są… raporty. Musisz wiedzieć gdzie były i są umieszczone linki. To zaoszczędzi Ci dużo czasu (i pieniędzy) na szukanie linków oraz ich analizę. Bez tego może być ciężko i zrzekanie się linków (czyt. wychodzenie z filtra) może nie udać się po pierwszej liście linków do usunięcia.

W przypadku powiadomienia o nienaturalnych linkach najważniejsze są… raporty. Musisz wiedzieć gdzie były i są umieszczone linki. To zaoszczędzi Ci dużo czasu (i pieniędzy) na szukanie linków oraz ich analizę. Bez tego może być ciężko i zrzekanie się linków (czyt. wychodzenie z filtra) może nie udać się po pierwszej liście linków do usunięcia.

Magdalena Cygan / Invisio

Pewnie każdy, kto ma z branżą SEO cokolwiek wspólnego, zauważył (choćby po coraz bardziej burzliwych dyskusjach na forach i blogach tematycznych), że w ostatnim czasie panuje w naszej branży coraz większa moda na „nowe sposoby pozycjonowania”. Polegają one albo na osłabianiu konkurencji – na ogół przy użyciu automatycznego, nienaturalnie wyglądającego linkowania linkami rotacyjnymi z różnych systemów wymiany linków konkurencyjnej domeny – aż do jej zafiltrowania, albo na coraz powszechniejszym pozbywaniu się linków prowadzących do własnej strony (jako że linki

Pewnie każdy, kto ma z branżą SEO cokolwiek wspólnego, zauważył (choćby po coraz bardziej burzliwych dyskusjach na forach i blogach tematycznych), że w ostatnim czasie panuje w naszej branży coraz większa moda na „nowe sposoby pozycjonowania”. Polegają one albo na osłabianiu konkurencji – na ogół przy użyciu automatycznego, nienaturalnie wyglądającego linkowania linkami rotacyjnymi z różnych systemów wymiany linków konkurencyjnej domeny – aż do jej zafiltrowania, albo na coraz powszechniejszym pozbywaniu się linków prowadzących do własnej strony (jako że linki

w ogóle przestają być według Google naturalne). Oba te przypadki wiążą się ze sobą (jeśli chcemy mieć wyniki, nienaturalnych linków trzeba się pozbyć) i są naprawdę gorącymi tematami, tak z perspektywy etyki pracy specjalisty SEO – jeśli w ogóle możemy jeszcze o etyce mówić – jak i w kontekście osiąganych rezultatów.

W ciągu ostatnich kilku miesięcy spotkałam się już z przypadkami depozycjonowania i miałam okazję przywracać stronom należne im miejsce w rankingu. Oto, jak mniej więcej wyglądał ten proces:

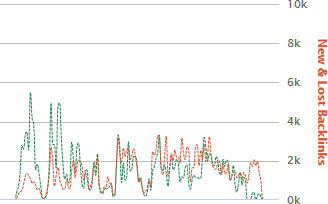

- Wykrycie „złego” linkowania – w grę wchodzi tutaj na ogół bieżąca analiza profilu linkowania i wynajdywanie zmian. Ciekawe informacje można wyłuskać z serwisów takich jak Ahrefs czy MajesticSEO (również za pomocą darmowych subskrypcji). Na przykład wykres linkowania za pomocą SWL-a ma przeważnie bardzo charakterystyczny kształt.

- Zbadanie na podstawie linków z GWT, jakiego typu linki prowadzą do witryny i wyselekcjonowanie tych, które mogą zostać uznane za spam. Mogą być to na przykład linki rotacyjne z SWL-a, linki z blastów, niskiej jakości katalogowanie itd. Ogólnie rzecz biorąc, najlepsza jest analiza ręczna, ale ostatnio popularne stają się narzędzia takie jak linkdetox.com, które z pewnością pomogą przynajmniej zasugerować, co wygląda podejrzanie. 😉

- Po gruntownej analizie i stwierdzeniu, które linki nam przeszkadzają w osiągnięciu celu – usunięcie jak największej ich liczby. W zależności od tego, jaki jest powód chęci podniesienia jakości swojego profilu linkowania, możemy między innymi:

- blokować możliwość linkowania z systemów wymiany linków (nie z każdego się da),

- usuwać linki w katalogach lub zmieniać ich anchory,

- zweryfikować procentowy udział linków site-wide poprzez poszukanie odpowiednich miejsc, w których linki tego typu się pojawiają, i ewentualne ich „zdjęcie”,

- oraz wiele, wiele więcej, czego nie da się opisać w kilku podpunktach. Jednym słowem: stawiamy na kreatywność i dokładną analizę. Im więcej linków uda się pozbyć w naturalny sposób, tym lepiej,

- zdobywać linki na słowa i frazy, które zneutralizują działanie obecnych linków śmieciowych (co jednak często bywa czasochłonne),

- prócz tego jest także Disavow Link Tool, które jednak wzbudza kontrowersje wystarczająco duże, by nie komentować go szerzej w tym miejscu.

- Po tym wszystkim – w momencie, gdy jesteśmy przekonani, że usunęliśmy, co mieliśmy usunąć, pozostaje prośba o ponowne rozpatrzenie witryny.

Koniec końców, najlepszym (i najbardziej naturalnym) sposobem na pozbywanie się linków, jest ręczna ingerencja w ich istnienie (zmiana anchora, usunięcie, modyfikacja atrybutu rel= itd.). Oczywiście nie zawsze jest to możliwe, jednak warto na tym skupić uwagę w procesie modernizowania profilu linkowania witryny. Wszelkie branżowe wynalazki, takie jak linkowanie automatami (blasty) czy SWL-e musimy dodatkowo unieszkodliwiać innymi sposobami – jakimi, to już sprawa naszej kreatywności. I jeszcze raz podkreślę: w całym toku działań naprawczych najważniejsza jest analiza linków, czyli stwierdzenie, czego należy się pozbyć, co należy zostawić, a co możemy „sobie darować”.

Karol Dziedzic / iSurvival

Jak szybko i efektywnie zrzec się niechcianych linków?

Jak szybko i efektywnie zrzec się niechcianych linków?

Niezbędnik potrzebny do wykonania zadania:

SiteCondition.com – Kombajn sprawdzający bardzo szczegółowo profil linków prowadzących do Twojej strony. Jeśli tylko dotrze do Ciebie informacja o premierze tego softu to natychmiast zarejestruj się i wrzuć pliki z linkami do analizy! Oszczędzisz masę czasu przy tworzeniu listy linków do disavow tool.

(spojler! Przewidywany czas oczekiwania na premierę to około 10 dni od czasu publikacji tego artykułu 😉 )

MajesticSeo.com – zweryfikuj swoją stronę i pobierz za darmo linki prowadzące do niej albo skorzystaj z płatnego pakietu.

Wersja 1

- wrzuć linki z GWT do SiteCondition

- po analizie wyeksportuj linki do Excela (na tym etapie zostały odrzucone linki, które już nie istnieją) a następnie:

- wyrzuć z listy linki nofollow

- z czystym sumieniem wywal wszystkie linki z seo skryptów z domen o niskiej jakości

- zerknij skąd prowadzą linki na exact match i ręcznie przejrzyj, czy nie prowadzą z jakiś spamów, tudzież z miejsc, gdzie link może wydawać się kupiony albo ogólnie rzecz biorąc „nienaturalny”

- dalej krok po kroku przemierzaj od linków o najmniejszej do największej jakości typując kolejne linki, których chcesz się zrzec

Tak przygotowaną listę wrzuć do Disavow Tool, po czym złóż prośbę o ponowne rozpatrzenie strony.

Docelowo SiteCondition stworzy automatycznie za Ciebie listę linków, których należy się zrzec. Jednak przy bardziej zawiłych projektach lepiej jeszcze czasem dodatkowo ręcznie na wyrywki sprawdzić wyniki analizy.

Wersja 2

Powtórz proces, tylko do analizowanego pliku dorzuć oprócz linków z GWT linki z MajesticSEO (duplikaty automatycznie zostaną odfiltrowane).

Chcesz bliżej poznać możliwości SiteCondition? Polecam obejrzeć ostatni #8 Polski SEO Hangout od 46 minuty. Prezentacja prowadzona przez twórcę – Radka Kuberę

Marcin Duraj / mkane

Jak wiemy, w ostatnim czasie, powiadomienia o nienaturalnym linkowaniu nie są rzadkością. Jest kilka rodzajów wiadomości, jakie otrzymujemy. Gdy dostaniemy powiadomienie, które jednoznacznie wskazuje na powód np. o tym, że kupujemy linki lub korzystamy z SWL, nie ma problemu z określeniem co powinno być usunięte.

Jeśli jednak powiadomienie informuje „ogólnie” o nienaturalnych linkach to możemy się jedynie próbować domyślić czego dotyczy.

W takim przypadku podejmując decyzję o usuwaniu linków powinniśmy pamiętać o dwóch aspektach, które musimy wziąć pod uwagę.

Pierwszy z nich to profil anchor tekstów a drugi to jakość stron, które emitują linki.

Google zwraca uwagę na nadmierne linkowanie na daną frazę nawet jeśli część linków pochodzi z dobrych, naturalnie linkujących witryn. Wiele razy widziałem witryny, na których właściciel umieścił linka naturalnie a były podane jako przykład nienaturalnego linkowania.

W takim przypadku najczęściej problem był tekst anchora, tym bardziej jeśli pozycje na frazy pokrewne tekstowi zakotwiczenia ulegną spadkowi.

Jakość stron linkujących powiązana jest z ogólnym profilem linkowania i często ten aspekt jest powodem powiadomienia o nienaturalnym linkowaniu.

Co to jest według mnie słaba witryna? Zwracam uwagę na PR, jakość wykonania, grafikę, treść oraz ilość i treść linków wychodzących itp.

Nie znając listy „złych linków”, podejmując decyzję o usuwaniu linków na początku usunąłbym najsłabsze jakościowo witryny.

Listę pobrałbym z GWT, uzupełniłbym ją listą z Ahrefs lub MajesticSEO oraz swoich źródeł.

W pierwszej kolejności sprawdziłbym PR oraz ilość linków wychodzących. Jestem dość restrykcyjny, więc na początek usunąłbym od razu linki z wszystkich domen z PR N/A bez ich przeglądania. W PR 0 zostawiłbym tylko te, które nie wyglądają na zaplecze i spam albo są naturalne.

Jeśli usuwamy bo dostaliśmy powiadomienie, po tych czynnościach wysłałbym pierwszą prośbę o ponowne rozpatrzenie. Jeśli linki są usuwane bo pozycje spadają po takim czyszczeniu często jest skok do góry, jeśli zostaną jeszcze jakieś inne linki 🙂

Jak usunęliśmy wszystko albo zostało ich niewiele, to nie liczmy na wielkie skoki do góry.

Jeśli mamy czas by podjąć z Google „grę” nie usuwałbym od razu wszystkich linków, tylko wycofałbym te najgorsze. Odpowiedzi na nasze prośby przychodzą szybko, można więc uratować te najlepsze co może przełożyć się na utrzymanie pozycji.

Jednak gdy wszystkie pozycje leżą od długiego czasu to warto wyczyścić wszystko by za jakiś czas zacząć pracę od początku, a w tym czasie nie tracąc czasu najlepiej zająć się witryną na nowej domenie.

Na koniec dodam, że moim zdaniem decyzja Google o wysyłaniu informacji o nienaturalnym linkowaniu, dokona większych zmian w SEO niż wszystkie zmiany algorytmów do tej pory.

Paweł Gontarek / Blog SEO

Wskazówki Zgreda do oczyszczania serwisu z kary za linki:

Wskazówki Zgreda do oczyszczania serwisu z kary za linki:

- skupiamy się na tym co jest w GWT w sekcji najnowsze linki oraz spis domen

- w pierwszej iteracji oczyszczamy na wstępie tylko to co mamy w GWT

- oczyszczaniu podlegają: katalogi z linkami w treści (wpkaty, seokatalogi przede wszystkim, katalogi z multikodami za grosze

- precle – samo usunięcie linka czy wstawienie nofollow czasem nie pomaga – artykuły z precli MUSZĄ wtedy zostać fizyczni usunięte

- jeśli precle to własne zaplecze bezapelacyjnie trzeba je skasować

- przeglądam też marketing szemrany – jeśli jest nachalny i dupowato prowadzony – dążę do usunięcia lub wstawienia NF

- usuwam wszelkie linki typu side-wide

- jeśli w stopce jest link z anchorem do autora (grafika, webmastera) – wstawiamy NF lub anchorem robimy adres WWW strony autora

- to czego nie można usunąć wrzucamy do DT

- po wszystkich czynnościach piszemy RR

- taką analizę należy przeprowadzić w ciągu 2-3 dni od daty pobrania linków z GWT gdyż mogą się one zmieniać

- jeżeli w pierwszej iteracji nie uda się uzyskać pozytywnego RR wracamy do początku analizując GWT

- dopiero po drugim negatywnym RR przeglądam dodatkowe narzędzia typu Majestic, Ahrefs czy inne

Marek Groński / MaxROY

„Nie ma jednej, skutecznej metody na oczyszczenie profilu z niechcianych linków, a narzędzie disavow powinno być ostatnią deską ratunku (używaną przeważnie do linków, nad którymi nie mamy żadnej kontroli).

Pierwszy, i chyba najtrudniejszy, krok to wytypowanie niechcianych odnośników. Każdy zdaje sobie sprawę z tego, że informacje udostępniane przez Google w GWT, to niepełne repozytorium, a więc koniecznie należy je uzupełnić danymi z MajesticSEO i/lub ahrefs. Gdy będziemy mieć jedną listę z unikalnymi wpisami o linkach można przystąpić do ich analizy. Gdy linków jest 100 czy 200, to można się pokusić o ich ręczną analizę (tylko po co?). Przy większej ilości ręczna analiza jest na tyle czasochłonna i nieefektywna, że trzeba znaleźć sposób by ją zautomatyzować. Jak to zrobić? Metod jest tyle ile definicji seo. Możemy skorzystać z narzędzi typu LinkRisk czy LinkDetox, jednak ze względu na ukryty schemat oceny linków nie można im zaufać w pełni, i w większości przypadków kończy się na ręcznym przeglądaniu 20-30% tego co narzędzia oznaczyły jak złe lub dobre.

Inną metodą (którą z powodzeniem stosuję) jest filtracja domen linkujących wg metryk TrustFlow i CitationFlow dostarczanych przez MajesticSEO. W tym celu wyznaczam tzw. TrustRatio, czyli stosunek TrustFlow do CitationFlow. Linki z domen których TrustRatio wyraźnie odstaje od średniej w niszy nadają się do usunięcia (oczywiście warto rzucić okiem na to co się tam znajduje zanim zgłosimy te domeny do disavow). Jeżeli mamy nad tymi linkami kontrolę, to je usuwamy. Jeśli nie, wrzucamy domenę do disavow. Siła tej metody polega na jej skalowalności – jeśli za pierwszym razem reconsideration zostanie odrzucony, nie musimy ponownie siedzieć godzinami nad backlinkami zastanawiając się nad tym jakie kolejne usunąć. Wystarczy podnieść próg TrustRatio i otrzymujemy nową listę domen, które mogą szkodzić naszej witrynie.”

Marta Gryszko / Lexy

Przy oczyszczaniu profilu linków, istotne jest zebranie odpowiednich danych do analizy. To od tego w największym stopniu zależy zarówno tempo prac, jak i ich skuteczność.

Przy oczyszczaniu profilu linków, istotne jest zebranie odpowiednich danych do analizy. To od tego w największym stopniu zależy zarówno tempo prac, jak i ich skuteczność.

Ograniczając się do pobrania listy linków z narzędzi dla webmasterów, ograniczamy liczbę danych do analizy (chociaż w ostatnich dniach Google zapowiedziało poprawę w tej kwestii). Ponadto, otrzymujemy tylko czyste dane w postaci lokalizacji tych linków, bez dodatkowych parametrów ani szczegółów na temat strony docelowej, użytego anchora ani nawet tego, czy link nadal się wyświetla. Jedyną pomocną daną jest data wykrycia linka, jednak to za mało.

Zazwyczaj kary za tzw. nienaturalne linki przychodzące są nakładane na serwisy z naprawdę dużą liczbą linków, która nie pozwala na w pełni ręczne działania i analizę link po linku. Dlatego właśnie potrzebujemy nie tylko uzupełnienia danych z WMT tymi z zewnętrznych narzędzi, np. Majestic SEO, ale też uzyskania jak najwięcej szczegółów o linkach (wspomniana już strona docelowa, anchor, informacja o indeksacji strony, rodzaj linka, tj. nofollow/dofollow, czy link nadal się wyświetla itp.), które i tak musielibyśmy sprawdzić odwiedzając każdą stronę z osobna. Informacje te pozwolą nam na to, aby przede wszystkim nie tracić czasu na odwiedzanie stron, na których linki od dawna się nie wyświetlają, jak również na to, aby część linków oznaczyć jako szkodliwe już na podstawie tych parametrów.

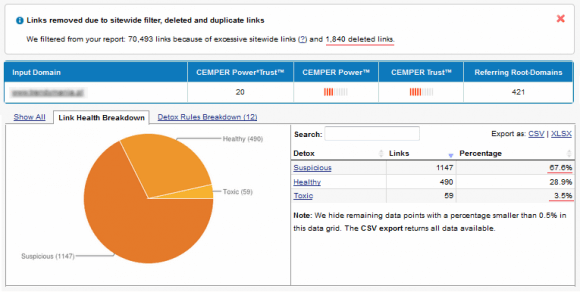

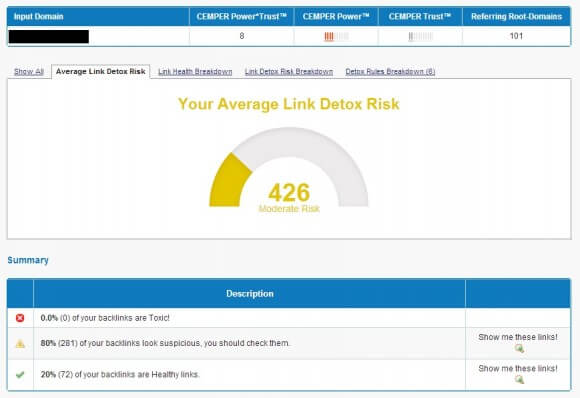

Do usprawnienia analizy linków można skorzystać z narzędzia Link Detox, które nie tylko gromadzi dane z różnych źródeł (w tym z narzędzi Google dla webmasterów), ale także oddziela od siebie linki istniejące od tych już usuniętych.

Z kolei prezentowane dane pozwalają już na etapie przeglądania linków znaleźć m.in. te wyświetlane na niezaindeksowanych stronach, z wyjątkowo słabym profilem linków, z określonymi anchorami. Ostatnia z tych danych ułatwi także wyłapanie linków pozyskanych przez konkurencję w wyniku prób depozycjonowania – linki takie często mają inne anchory, niż te stosowane przez nas, albo kierują do adresów w innej formie od standardowej (np. linkowanie do http://lexy.com.pl zamiast http://www.lexy.com.pl). I dopiero na podstawie takich pełnych danych wyjściowych możemy przejść do dalszej analizy.

Należy jednak pamiętać o tym, że – wbrew obiegowej opinii – tego typu narzędzia nie myślą za nas i nie wykonają samodzielnie całej pracy. To tylko (albo aż) kompleksowe wsparcie dla dalszych działań, w wyniku których sprawnie uda się dojść do listy potencjalnie szkodliwych linków, jakie należy usunąć, ale także linków wartościowych, na których pozyskiwaniu należy się skupić w przyszłości.

Łukasz Iwanek / Internetica

Proces oczyszczania profilu rozpoczynam zawsze od eksportu wszystkich linków z Google Webmaster Tools. Następnie sprawdzam PR wszystkich domen głównych, zostawiając tylko te które nie mają go wcale lub dla których wynosi on 0 (warto w tym celu skorzystać z opcji jakie oferuje Scrapebox). W ten sposób tworzę listę potencjalnych miejsc słabej jakości. Następnie w zależności od rodzaju linków, staram się usunąć je samodzielnie, a jeśli nie jest to możliwe – korzystam z narzędzia Google Disavow Tools. Ocenić należy także rozkład anchorów. Moim zdaniem rozkład brandowych anchorów powinien oscylować w granicach 70%. Jeśli jest on niższy, należy podjąć odpowiednie działania. Unikamy linków Site-Wide, które w ostatnim czasie często były przyczyną problemów, zwłaszcza jeśli znajdowały się w stopce. Linki warto pozyskiwać z branżowych katalogów, ponieważ jest to najbardziej naturalne miejsce, a dodatkowo zapewnia wartościowy ruch na stronę

Konstantin Kanin / KonstantinKanin.com

Specjalizuję się w pozycjonowaniu w Runecie, gdzie monopolu na rynku wyszukiwania nie ma, a Google, w zależności od branży, generuje 20-35% ruchu organicznego. W związku z tym, w rosyjskim SEO mamy trochę inne podejście do pozycjonowania, profilu linków i oczywiście do usuwania/rezygnacji z „kiepskich” linków.

Przede wszystkim, należy uwzględnić fakt, że niektóre linki, postrzegane przez Google jako „słabej jakości” mogą świetnie działać w Yandexie, który z kolei nie stosuje takich kar i w większości przypadków po prostu nie uwzględnia te „kiepskie” odnośniki. Więc przed wprowadzeniem narzędzia Disavow dostając filtra od Google, stawaliśmy przed wyborem – wyłączyć zakupione linki w Sape.ru i usuwać linki z artykułów kosztem dobrych pozycji w Yandexie, czy kontynuować zakup linków, zapominając o dodatkowym ruchu z Google? Najczęściej odpowiedź była oczywista – nie patrząc na dodatkowe wydatki, bardziej się opłaca dodać extra budżet na pozycjonowanie w Yandexie, niż usuwać wszystkie linki i zaczynać pozycjonowanie w obydwóch wyszukiwarkach od nowa.

Natomiast od momentu kiedy pojawił się instrument Disavow, wszystko stało się prostsze – możemy śmiało rezygnować z linków „słabej jakości”, usuwając sankcje, a jednocześnie mamy niezmienne pozycje w Yandexie.

Jeśli chodzi o narzędzia SEO, coraz częściej pojawia się soft do kompleksowej oceny wydawców, który jest dopasowany pod warunki Runetu. Innymi słowy, narzędzie bierze pod uwagę nie tylko znane dla wszystkich specjalistów na Zachodzie parametry od Majestic SEO lub Moz, ale na przykład parametry Mail.ru lub Yandexa (zaindeksowanie stron, TIC, obecność w katalogu Yandex, wiadomości o wirusach wg Yandexa itd.); analiza backlinków przez rosyjski serwis Solomono.ru; analiza ruchu za pomocą SpyWords.ru lub SemRush – ilość zapytań na które witryna ma ruch organiczny bądź reklamuje się w Adwords lub Yandex.Direct; ilość udostępnień we Vkontakte.ru lub Odnoklassniki.ru i inne.

Kompleksowo, wszystkie te parametry, których jest już około 60, dają dość jasne przedstawienie o wydawcy i „jakości” linków z jego podstron. Oczywiście że każde z tych narzędzi ma własną formułę wskaźnika Trust lub tzw. poziomu zaspamowania witryny linkami wychodzącymi. Każdy pozycjoner sam wybiera której formułce ufać. Przykłady programów, które mogę polecić – CS Sape Master stworzony specjalnie dla giełdy Sape.ru, oraz FastTrust – uniwersalne narzędzie do oceny jakości linków.

Paweł Kijko / Klewer

Filtry nakładane na strony w wyniku działań Google na przełomie czerwca i lipca wyraźnie pokazały jak wielką uwagę Google przykłada do wysokiego stopnia zróżnicowania linków. Linki wskazane w Narzędziu dla Webmasterów oraz wskazane przez Link Detox pomagają wykryć, choć nie w 100%, linki które mogą powodować takie działanie. Niestety nie zawsze pokrywają się one w obu narzędziach.

Standardowe wskaźniki typu BL, PR, Alexa, TRUST RANK (domeny głównej i podstrony linkującej) kategoryzują linki na „lepsze – gorsze”. W zależności od ich ilości można ustawić sobie pewne progi akceptacji wartości linku, z kolejnym zgłoszeniem usunięcia filtra przesuwając je w górę, ponieważ da się zauważyć pewną losowość działań pracowników Google w tym obszarze. Dostało się trochę SEOKATALOGOM, w niektórych z SEO została tylko nazwa. Warto przy tym wszystkim kierować się również logiką, selekcjonując linki również po … nazwach i dokładnie przeglądać serwisy na których są umieszczone. Patrząc na suche wskaźniki zapominamy że strony takie jak popularne regionalne serwisy, strony partnerów klienta nie konieczne muszą być zgłaszane do zrzeczenia się w Narzędziach dla Webmasterów ze względu na swoją tematyczność.

Profil zróżnicowania pochodzenia linków jest najwidoczniejszym elementem zmian w algorytmie. Dodatkowo jednak wykryłem że znacznie większej istotności nabrał fakt linkowania podstron witryny. Teraz strona, która ma linki prowadzące jedynie do witryny głównej szczególnie zwraca uwagę Google i budzi większe podejrzenia o brak zgodności z wytycznymi Google

Strona otrzymała filtr mimo że Link Detox nie wskazuje ani jednego toksycznego linka. Linki które spowodowały filtr ukryte są w suspicious.

Strona otrzymała filtr mimo że Link Detox nie wskazuje ani jednego toksycznego linka. Linki które spowodowały filtr ukryte są w suspicious.

Mariusz Kołacz / SocialTrends

W swojej prezentacji skupię się na analizie i przygotowaniu pliku Disavow. Na co należy zwrócić uwagę, jak sobie ułatwić pracę oraz na koniec pokażę na 5 przykładach, jakie linki mogą zaszkodzić Twojej stronie. Ograniczę się tylko do najważniejszych kwestii.

Zatem pobrałeś listę linków, które prowadzą do Twojej witryny i masz zamiar ją przeanalizować. Zastanawiasz się jak to dobrze zrobić? Otwierasz plik CSV w arkuszu kalkulacyjnym i co dalej? Każdą analizę linków rozpoczynamy od posortowania domen według kolejności alfabetycznej. Pozwoli to pogrupować domeny. Dlaczego sortowanie? Będą sytuacje, gdzie sprawdzenie pierwszych kilku linków, spowoduje że wyrobisz sobie zdanie na temat danej domeny, wtedy z łatwością oznaczysz wszystkie linki jako szkodliwe oszczędzając cenny czas.

Jakimi parametrami kierować się podczas oględzin? Przede wszystkim należy popatrzyć na aktualny PR witryny, jeśli jest n/a bądź 0 należy taką stronę oznaczyć do potencjalnego usunięcia. UWAGA! Nie każda strona z PR n/a lub 0 jest zła. Bardzo często strony zapleczowe mają takie wskaźniki, jednakże przez to że posiadają unikalną wartościową treść nie zostaną zakwalifikowane do usunięcia. Podobnie jest z preclami (choć tych będzie znacznie mniej). Pamiętaj – o klasyfikacji decyduje kilkadziesiąt czynników, nigdy nie wyciągaj wniosków bazując tylko na jednym parametrze!

Wracając do parametrów, w części przypadków uwzględnić należy także wskaźnik Alexy oraz STR (SM Trust Rank). Są to wskaźniki pomocnicze, które w części przypadków mogą przesądzić o losie domeny.

Kolejną istotną kwestią, a nawet koronną jest sprawdzenie, czy dana domena znajduje się w indeksie wyszukiwarki Google. Wszelkie domeny, które zostały wyindeksowane (zbanowane) należy dodać do pliku disavow. Co jest jeszcze istotne? Liczba linków wychodzących, długość wpisu i liczba linków na wpis (zwykle 3 na 1500-1800 znaków co jest grubą przesadą), unikalność treści… Cała klasyfikacja obejmuje kilkadziesiąt różnych czynników, które odnoszą się do konkretnych przypadków (stron). W tej krótkiej prezentacji nie jestem w stanie przekazać nawet 10% informacji które posiadam.

Obiecałem jeszcze podać 5 przykładów linków, które mogą zaszkodzić. Zatem jakich linków należy unikać?

- SWL, linki sitewide, blogroll (są odstępstwa od tej reguły).

- Linki z wielopoziomowych subdomen. Uważnie dobierajmy miejsca skąd pozyskujemy linki, unikajmy domen typu… to.jest.moja.domena.pl lub grup na subdomenach kat1.domena.pl, kat2.domena.pl, kat3.domena.pl, nie mówię już o regionalkach czy domenach funkcjonalnych tam także pozycjonerzy hodują niezłe wylęgarnie linków.

- Precle wielojęzyczne gdzie ładuje się artykuły w różnych językach PL, EN, RU, chińskie i jeszcze Bóg wie jakie.

- Linki w komentarzach na zaspamowanych blogach. Czy myślicie że Wasz link dofollow będący 1000 w kolejności coś Wam da? Owszem – powiadomienie o nienaturalnych linkach!

- Zaspamowane fora dyskusyjne, gdzie z jednej podstrony mamy tonę linków wychodzących.

Przykładów oczywiście można podać znacznie więcej.

Wiele osób nawet nie zdaje sobie sprawy jak żmudnym zadaniem jest analiza profilu linków. Wyobraź sobie, że masz do przeanalizowania 30 tysięcy linków, jeśli przyjąć że masz szybkie łącze internetowe i na każdą analizę (klasyfikację) poświęcisz 10 sekund, Twoja wydajność wynosi wtedy około 6 stron na minutę, 360 w przeliczeniu na godzinę. Nie trudno policzyć, że mając do analizy 30 tysięcy rekordów, przeanalizowanie całości zajmie 83 godziny! A należy pamiętać, że na czas oględzin wpływa czas pełnego załadowania witryny + czas niezbędny do oceny strony. Oczywiście to są dane poglądowe, można ułatwić sobie pracę na różne sposoby, nie zmienia to jednak faktu, że jest to bardzo czasochłonny proces.

Na koniec wspomnę o mojej inicjatywie. Z racji tego, że chcę lepiej zrozumieć cały mechanizm oceny linków przez Google, wyszedłem z inicjatywą bezpłatnego sprawdzenia profilu linków dla wybranych stron. Co miesiąc całkowicie nieodpłatnie pomogę jednej witrynie – przeanalizuję profil linków, sklasyfikuję odsyłacze, wybiorę te szkodliwe i przygotuję plik do narzędzia Disavow Tool. Kilka osób napisało mi na PW, że chyba jestem po… że oferuję coś takiego za free. No cóż, za wiedzę także płaci się krocie, szczególnie w SEO (wiecie doskonale ile kosztują szkolenia w tej branży). O szczegółach mojego przedsięwzięcia można przeczytać tutaj.

Krzysztof Marzec / DevaGroup

Uważam, że najlepszą metodą jest zapobieganie – jednym z kluczowych błędów popełnianych przez seo wpadających w filtry jest trzymanie się oklepanych metod. Używając identycznych narzędzi co reszta branży i tych samych „złotych” schematów linkowania zwiększamy prawdopodobieństwo wystąpienia kłopotów. Każde linkowanie czy to z precli, masowych multikodów, SWL czy śmiecio-zaplecz ma przypisane ryzyko, decydując się na taką czy inną metodę podnosimy sobie szanse na przyszłe problemy. Czasem kreatywne podejście – wysokiej jakości zaplecze, mniejsza ilość ale mocno podlinkowanych linków lub unikanie najpopularniejszych metod i części bazy publicznej da lepsze wyniki pozycjonowania i brak problemów przez lata.

W razie problemów z działaniami ręcznymi pamiętaj o 3 faktach:

- Disavow tool to narzędzie obosieczne, pokazujące Google zaplecza i odpowiedzialne za dalszy upadek bazy publicznej.

- Nie bądź nadgorliwy. Sprzątając nigdy nie zgłaszaj dużych ilości linków – Google może wcale nie uważać ich za śmieci.

- Google czasem podaje naturalne linki jako przykłady „złych linków”, nie usuwaj ich – napisz do Google, że zaszła pomyłka.

Na koniec dodam, że kluczowe jest stałe monitorowanie własnego profilu i liczby linków w MajesticSEO lub Google Webmaster Tools. W dobie karania za linki przychodzące 'blastowanie’ konkurencji stało się niebezpiecznie popularne i niestety zbyt często skuteczne.

Sebastian Miśniakiewicz / SEO Profi

Najważniejszą moim zdaniem kwestią przy oczyszczaniu profilu linków jest znajomość miejsc, w których zostały one umieszczone. Z mojego doświadczenia w wyciąganiu stron z filtrów jasno wynika, że im bardziej profil jest „zakręcony” oraz im mniej właściciel strony wie, jak wyglądało pozycjonowanie, tym trudniej taką stronę jest wyciągnąć z filtra.

Bardzo ważne w tym kontekście jest także i to, aby właściciel strony (i/lub firma SEO) miał dostęp do linków, które umieszcza – w praktyce: aby mógł je usunąć. Dla Google przy czyszczeniu profilu linków ważniejsze jest to, że jakieś linki zostaną usunięte – a nie to, ile ich wpiszemy do disavow toola.

Do wychodzenia z filtra usuwam TYLKO I WYŁACZNIE Narzędzi dla Webmasterów. Moim zdaniem analiza linków Ahrefs.com czy Majestic SEO to strata czasu. Podstawa wyjścia z filtra to analiza linków widocznych w Narzędziach oraz dobre udokumentowanie działań „oczyszczających” – a nie załączanie pliku disavow z kilkudziesiącioma tysiąca domen/linków.

Właścicielom stron (tym, co wyszli z filtra i tym, którzy myślą o pozycjonowaniu) zawsze sugeruję, aby bardziej przykładali się do jakości pozyskiwanych odnośników, z prostego powodu – z moich obserwacji wynika np., że duża ilość złych linków potrafi obniżać pozycję strony – i samo pozbywanie się ich podnosi stronę w SERPach.

Jarosław Miszczak / Go3

Zgodnie z oficjalnym stanowiskiem Google (które przedstawił John Mueller), w analizie linków przychodzących wystarczy opierać się o dane udostępniane przez Centrum Google dla Webmasterów. Z mojego doświadczenia wynika jednak, że nie zawsze to może wystarczyć. Miałem przykład strony dla której usunięcie i zgłoszenie przez Disawow Tool linków nie wystarczyło do zdjęcia filtra. Co więcej, Google zaprezentowało mi jako przykłady tzw. „szkodliwych linków” 2 odnośniki, których próżno szukać w GWT. Po głębszej analizie danych z Majestic SEO okazało się, że do witryny prowadzi całkiem sporo niskiej jakości linków, które zapewne odpowiadają za odrzucenie prośby o ponowne rozpatrzenie. Mimo iż wyszukiwarka o nich wie, nie pokazuje ich na liście linków w GWT.

Z tego właśnie powodu polecam rozszerzenie swojej pracy przy czyszczeniu profilu linków przynajmniej o przejrzenie danych np. z Majestic SEO. Jeżeli zauważycie znaczące różnice w stosunku do listy linków z GWT, należy przeprowadzić szczegółową analizę uwzględniając obydwa źródła informacji o odnośnikach. Dzięki integracji Majestic SEO z GWT, pobranie listy linków jest banalnie proste (wystarczy połączyć konto Majestic SEO z GWT) oraz – dla zautoryzowanej witryny – zupełnie bezpłatne. Czasem te dodatkowe kilkanaście procent czasu więcej przy analizie linków może zaoszczędzić Wam opóźnienia procesu wyjścia z filtra o kilka tygodni. Moim zdaniem warto.

Paweł Rabinek / RedSEO

Oczyszczanie profilu linków to sprawa bardzo indywidualna i wygląda inaczej dla każdej strony. Jest jednak kilka uniwersalnych rzeczy o których warto pamiętać w czasie robienia porządków. Aby poprawić profil naszych linków, powinniśmy skorzystać z kilku technik zanim skorzystamy z narzędzia do zrzekania się linków Google Disavow Tool.

Po pierwsze musimy wiedzieć ile, jakich i skąd mamy linki kierujące do naszej strony. Głównym źródłem informacji będzie wykaz linków z Narzędzi Google dla Webmasterów. Jest ona jednak ograniczona ilościowo oraz składa się wyłącznie z listy URL , warto więc skorzystać z dodatkowych narzędzi jak choćby ScrapeBox do pobrania anchortext linków. Poza danymi z Narzędzi dla Webmasterów, mamy także MajesticSEO gdzie za darmo możemy pobrać raport naszej strony, Ahrefs, OpenSiteExplorer oraz Instant Backlink Explorer od CognitiveSEO.

W przypadku linków kierujących do podstron w naszym serwisie, możemy wprowadzić zmianę adresów URL podstron z wstawieniem błędu 404 na podlinkowane podstrony. W ten sposób odetniemy się od linków, ponieważ wskazują one stronę 404 . Sprawdza się to jednak tylko w sytuacji, gdzie chcemy się pozbyć wszystkich linków kierujących do danej podstrony, a nie tylko wybranych. Jest to też rozwiązanie, które na pewnych stronach może nie być możliwe w realizacji z różnych względów.

Następna rzecz to usunięcie niechcianych linków. Tutaj sprawa jest prosta – co można usuwamy. Robimy listę URLi z usuniętym linkiem, którą wykorzystamy w żądaniu ponownego rozpatrzenia strony. Jest tu jednak haczyk, a w zasadzie wielki i ostry hak! Usuwając linki dajesz jasny sygnał do wyszukiwarki: „Usunąłem te linki, mam więc nad nimi kontrolę. Skoro mogłem je zdjąć, to znaczy, że zapewne je kupiłem, wymieniłem albo to moje zaplecze…”. W tej sytuacji musisz liczyć się z faktem, że w niedalekiej przyszłości miejsca skąd zdjąłeś linki trafią pod lupę Google i będą „spalone” w dalszym link buildingu! Nie licz na to, że Google nie wykorzysta tej informacji.

Ostatecznym rozwiązaniem jest skorzystanie z narzędzia zrzekania się linków Google Disavow Tool. Wrzucamy tu to, czego nie chcemy i czego nie udało nam się usunąć. Wylądują tu więc zapewne stare katalogi, zapomniane precelki itp. Robimy też kopię listy na Dysku Google, którą wykorzystamy w zgłoszeniu ponownego rozpatrzenia witryny.

Gdy wszystko jest gotowe i sprawdzone, wysyłamy zgłoszenie o ponowne rozpatrzenie naszej strony w wynikach Google. Opisujemy co udało nam się dokonać w sprawie oczyszczenia linków, czego nie udało się dokonać, podsyłamy listy do dokumentów na Dysku Google z listą plików usuniętych i listą plików zgłoszonych w Disavow Tool (pamiętamy o włączeniu udostępniania dla osób mających link!!!) oraz deklarujemy zmianę strategii marketingowej na zgodną z wskazówkami jakościowymi Google. Jeżeli nasza analiza, działania i deklaracja w zgłoszeniu były szczere i solidnie przygotowane, po kilku dniach możemy liczyć na sukces. Jeżeli nie, próbujemy ponownie, bardziej szczegółowo.

Scenariusz jest sprawdzony i działa! Pozostaje jednak pewne „ale” z którym zapewne wkrótce branża SEO będzie musiała się zmierzyć… Google rozsyłając hurtowo informacje o ręcznych działaniach związanych z linkami przychodzącymi oraz z wykorzystaniem algorytmów jak Pingwin, zmusza specjalistów SEO do usuwania linków i zgłaszania ich wyszukiwarce. Sami podajemy na tacy informacje jak i skąd linkujemy, co oznacza, że już teraz albo w najbliższej przyszłości takie strategie linkowania będą kompletnie nie skuteczne! Jest to niestety gra w której to Google rozdaje karty i ustala zasady…

Bartosz Sikorski / SBart

Google nigdy specjalnie dobrze nie radziło sobie z algorytmicznym rozpoznawaniem linków dodawanych przez pozycjonerów. Co jakiś czas pojawiały się aktualizacje algorytmu, których celem miały być np. SWLe. I faktycznie niektóre witryny, te które ich nadużywały, dostawały po uszach. Natomiast witryny dla których SEO robione było stosunkowo z głową, czyli np. z wykorzystaniem zaplecz, precli, katalogów i także SWLi, ale w rozsądnych ilościach, z reguły trzymały się dość stabilnie na pozycjach. Niestety sytuacja ostatnio się trochę zmieniła i w mojej opinii, to głównie efekt wprowadzenia narzędzia Disavow Tool. Google nie radząc sobie z wykrywaniem linków SEO, wpadło na pomysł żeby robili to sami pozycjonerzy poprzez genialne w swojej prostocie wspomniane narzędzie Disavow Tool. W końcu kto zrobi to lepiej, jak nie osoby które same te linki pozyskują.

Może odrobinę przesadzę, ale tylko odrobinę, porównując działanie Disavow Tool do pętli zaciskającej się na szyi branży SEO. Pracownicy SQT zapewne przeglądają witryny często zgłaszane za pośrednictwem Disavow Tool i po pierwsze karzą te, które nie są zgodne z restrykcyjnymi wytycznymi, a po drugie mają doskonały materiał by móc wprowadzać rozwiązania algorytmiczne pozwalające na automatycznie ich wykrywanie. Efektem tego są spadki pozycji witryn, do których duży procent prowadzących linków, to strony ukarane przez SQT i oznaczone przez algorytm wyszukiwarki jako serwisy wykorzystywane w celach manipulacji pozycjami. Gdy pozycje takiej witryny spadną, pozycjoner by je odzyskać oczywiście zgłasza wszystkie, w jego opinii, złe linki do Disavow Tool i w taki właśnie sposób wspomniana pętla coraz bardziej się zaciska.

Kiedy korzystać z Disavow Tool?

W całym procesie usuwania złego profilu linków sugeruję by zgłoszenie do Disavow Tool traktować jako ostateczność. Skorzystanie z Disavow Tool może okazać się konieczne w sytuacjach gdy na stronę nałożono ręczy filtr za nienaturalne linki przychodzące, których niestety usunięcie jest niemożliwe. Wtedy, przed zgłoszeniem prośby o ponowne rozpatrzenie witryny, musimy niestety wykazać się przed SQT jakimikolwiek działaniami. Natomiast w każdym innym przypadku (np. filtrów algorytmicznych), uważam że jesteśmy w stanie obejść się bez Disavow Tool.

Pół biedy gdy dostaliśmy filtr algorytmiczny, ale mamy możliwość odpięcia szkodliwych linków (np. SWLi). Po ich usunięciu i odczekaniu kilku tygodni pozycje z reguły powoli zaczynają wracać. Trzeba wtedy jedynie zadbać o zdobycie nowych, bardziej wartościowych linków, które pozwolą utrzymać wysokie i stabilne pozycje na dłużej.

Niestety ostatnio często mam do czynienia z witrynami, których poprzedni pozycjonerzy nie oszczędzali lub sytuacjami w których obecni klienci, bez wcześniejszej konsultacji, wykupują różnego rodzaju usługi SEO (np. masowe katalogowanie w śmieciowych katalogach bez moderacji). Niedawno trafił mi się także przypadek w którym ktoś przeprowadził dość skuteczną próbę depozycjonowania, właśnie przez masowe dodawanie do katalogów do których ja bym nawet swojego zaplecza nie zgłosił. Witryny te łączy to, że prawdopodobnie otrzymały filtry algorytmiczne, ale usunięcie linków, które były przyczyną spadków pozycji jest w zasadzie niemożliwe. Co wtedy robić?

Moje wskazówki

Osobiście, w sytuacjach gdy kara nałożona jest algorytmicznie, a usunięcie szkodliwych linków jest niemożliwe, zamiast poświęcać czas na przeglądanie setek, czasem tysięcy linków i tworzenie pliku do Disavow Tool, przeprowadzam terapię polegając na zdobywani linków z serwisów co do których mam pewność, że cieszą się dużym zaufaniem w oczach wyszukiwarki. Jako anchory unikam wtedy stosowania pozycjonowanych fraz, wykorzystuje np. nazwę firmy, witryny lub sklepu. W większości przypadków pozwala to na stopniowe odbudowywanie i stabilizację pozycji. Choć zdarzają się także przypadki beznadziejne, gdy szkodliwych linków jest na tyle dużo, że ratowanie witryny może okazać się zbyt czasochłonne i po prostu nieopłacalne.

Nie będę skupiał się na konkretach, jak i gdzie linkować, bo tego dotyczył poprzedni artykuł ze wskazówkami na Silesiasem (Link Building – 35 rad jak tworzyć i zdobywać linki), natomiast polecam lekturę artykułu Lexy, który pojawił się już jakiś czas temu:34 pomysły na zdobycie linków.

Artykuł ten, jest nie tylko zbiorem ciekawych i wartościowych serwisów gdzie warto dodać linka, ale może być przede wszystkim inspiracją do tego by samemu poszukiwać takich miejsc i tworzyć własne prywatne listy.

Ktoś na pewno pomyśli, że to wszystko kosztuje zbyt dużo czasu i nie rzadko pieniędzy, natomiast ja od razu odpowiem, że SEO się zmienia i zautomatyzowane działania powoli będą miały coraz mniejszą skuteczność. Dlatego sugeruję już teraz stosować coraz bardziej zindywidualizowane podejście do pozycjonowanych witryn i nie zawsze korzystać z automatycznych rozwiązań zarówno przy zdobywania linków, jak i wyznaczaniu tych, które warto usunąć.

Ewelina Szczecińska / Artevia

Jak czyścić profil linków? Systematycznie i… z głową. Jeśli filtr jeszcze nas nie dopadł, ale przeczuwamy, że to kwestia czasu (np. w przeszłości pozyskiwaliśmy odnośniki z zaniedbanych precli, kupowaliśmy linki na Allegro i popełnialiśmy inne tego typu błędy młodości) przeanalizujmy linki prowadzące do naszej strony. Takie świeże spojrzenie pozwala często odkryć strony, które aktualnie są zawirusowane lub zbanowane w Google, są zwyczajnymi „farmami linków” lub też przeładowane reklamami. I z takimi serwisami rzeczywiście lepiej się rozstać (poprzez umieszczenie domeny w pliku disavow.txt lub – i to jest opcja trudniejsza, ale zdecydowanie najlepsza – kontakt z administratorem strony z prośbą o usunięcie odnośnika).

Jeśli już trafił nam się filtr – zachowajmy spokój i nie rwijmy włosów z głowy 😉 Nie ograniczajmy się też do przeskanowania strony LinkDetoxem. Niewątpliwie jest to narzędzie pomocne, ale oprócz niego wykorzystajmy też własną wiedzę i zwyczajnie (choć to katorżnicza robota) przejrzyjmy dokładnie wszystkie linki, które prowadzą do naszej strony. Których się pozbyć?

- ze stron zbanowanych lub zawirusowanych

- z zaplecz niskiej jakości (przeładowanych reklamami i/lub odnośnikami wychodzącymi)

- z „farm linków” (zaniedbanych katalogów, zwykle opartych jeszcze na skrypcie qlWeb)

Usuwamy też dodatkowe odnośniki z katalogów, w których umieściliśmy je w treści opisu (tu zwykle wystarczy zwyczajne zalogowanie się do panelu w danym katalogu i edycja wpisu, podczas której usuniemy „nadprogramowe” linki).

Podczas analizowania profilu linków dobrze jest zwrócić uwagę na to czy linki są zróżnicowane. Jeśli mamy odnośniki tylko z precli albo tylko z jednego typu katalogów (dodatkowo z linkami w treści), zadbajmy też

o przyrost odnośników z innych miejsc (choćby katalogów opartych na autorskich skryptach). Warto również wykorzystać ten moment do popracowania nad samą stroną i ulepszenia jej, o ile wcześniej żadne prace optymalizacyjne nie były na niej prowadzone.

I na sam koniec – nie nadużywajmy Disavow Tool. Wrzucanie do niego wszystkiego „jak leci” ma sens tylko wtedy, gdy jesteśmy przekonani, że umieszczamy w pliku disavow.txt ewidentny spam, który i tak nie służył stronie (niskie pozycje jeszcze przed nałożeniem filtra). Umieszczanie w nim setek domen „profilaktycznie” może skończyć się spadkiem pozycji dla strony, a przecież nie o to przy walce o zdjęcie filtra chodzi.

Przemek Sztal / Performance Media

Oczyszczanie profilu linków to bardzo szeroki temat, o którym można napisać powieść rzekę. Ostatecznie zdecydowałem się na przedstawienie wskazówki technicznej, ułatwiającej analizę linków przychodzących osobom mniej doświadczonym.

Oczyszczanie profilu linków to bardzo szeroki temat, o którym można napisać powieść rzekę. Ostatecznie zdecydowałem się na przedstawienie wskazówki technicznej, ułatwiającej analizę linków przychodzących osobom mniej doświadczonym.

Narzędzia narzędziami, liczy się intuicja

Procesu analizy profilu linkowania nie można całkowicie zautomatyzować, ponieważ przy takim podejściu w większości przypadków odpowiedź na prośbę o ponowne rozpatrzenie zgłoszenia witryny zostanie odrzucona. Z drugiej strony ręczna ocena każdego odnośnika, to syzyfowa praca. Jeżeli witryna jest popularna, to zanim ukończymy jedną analizę, w GWT pojawią się setki nowych linków.

Z pomocą przychodzą różne narzędzia, pozwalające na automatyczne pobranie parametrów stron linkujących (ja w pracy z linkami bardzo cenię sobie wtyczkę SEO Tools for Excel). Ale koniec końców i tak pozostaniemy z listą linków, które będziemy musieli ocenić organoleptycznie.

A może ograniczyć dane?

Analizę linków pobranych z Narzędzi dla webmasterów Google można zasadniczo ograniczyć do analizy domen linkujących do naszego serwisu. W tym celu z adresów URL należy wyciąć sam adres hosta. Można napisać własną regułę w arkuszu kalkulacyjnym, ale funkcja UrlProperty([nasz-adres-url];”

Maczeta zamiast skalpela

Podczas zabaw w analizę linkowania nie spotkałem się z sytuacją, w której z jednej domeny prowadziłyby jednocześnie linki nienaturalne (te, których chciałbym się pozbyć) oraz wartościowe (te, które chciałbym pozostawić). Oczywiście taka sytuacja może mieć miejsce, ale są to wyjątkowe przypadki. Dlatego właśnie w analizie wystarczy wykorzystywać pojedyncze przykłady stron linkujących z danej domeny.

Poza tym podczas wykluczania linków warto korzystać z maczety zamiast skalpela (operator domain: zamiast wykluczania pojedynczych adresów URL), pamiętając że cięcia muszą być precyzyjne.

P.S. Cyrus Shepard w ramach testów do wykluczania linków użył siekiery i przekonał się, że można sobie nią

Case study: naczynia połączone

Na deser przedstawię ciekawe studium przypadku dla dwóch witryn: www.przykladowa.com i blog.przykladowa.com (imiona bohaterów zostały zmienione). W obu przypadkach w narzędziach dla webmasterów widnieje informacja o działaniach ręcznych podjętych w stosunku do nienaturalnych linków przychodzących. Po oczyszczeniu profilu linkowania witryny www.przykladowa.com zostaje przesłana prośba o ponowne rozpatrzenie, która skutkuje wycofaniem ręcznych działań. Po pewnym czasie znika też powiadomienie w sekcji “Działania ręczne” dla serwisu www.przykladowa.com. Okazało się, że jednocześnie zniknęło również powiadomienie dla subdomeny blog.przykladowa.com, która została “ukarana” za linki prowadzące do głównej domeny.

Wojtek Tyluś / WojtekTylus.com

W celu stworzenia pliku z nienaturalnymi linkami korzystam z listy znajdującej się w Narzędziach dla Webmasterów oraz posiłkuję się listami z Ahrefs i Majestic SEO na których niejednokrotnie znajdują się strony, których GWT z jakiegoś powodu nie wziął pod uwagę.

Poglądowy wzór strony oraz profil linków, który może być sprzeczny z wytycznymi Google, na przełomie 5 lat zmienił się prawie o 180 stopni o czym pisała niedawno na swoim blogu Marta Gryszko. Dlatego też należy rzetelnie podejść do wyboru linków, które zamierzamy zgłosić. Róbmy to z głową, nie usuwajmy wszystkiego jak leci, ponieważ zamiast pomóc możemy sobie jeszcze bardziej zaszkodzić.

Podczas procesu oczyszczania profilu linków szczególną uwagę należy zwrócić na to czy strony linkujące do nas, np. katalogi czy precle znajdują się na powtarzających się szablonach. Czy linki pochodzą z Systemów Wymiany Linków. Ponadto warto sprawdzić na jakich domenach znajdują się te linki – za podejrzane można uznać domeny darmowe oraz regionalne. Wiedząc już z jakich domen i jakich jakościowo stron pochodzą linki warto zwrócić uwagę w jakiej formie one występują. Powinna zapalić się nam czerwona lampka jeśli znaczna większość linków prowadzących do naszej strony będzie skierowana na anchor exact match.

Prócz oczyszczenia profilu linków, przed zgłoszeniem listy nienaturalnych linków i wysłaniu prośby o ponowne rozpatrzenie, zawsze dokonuję dodatkowo przeglądu optymalizacji, a także sprawdzam czy w Narzędziach dla Webmasterów znajdują się informacje o pojawiających się błędach. Nie mam potwierdzenia jaki wpływ na ogół ma poprawiona optymalizacja, wolę jednak pokazać pracownikom Google, sprawdzającym stronę, że podszedłem do tematu rzetelne i kompleksowo.

Zapisz się do newslettera wypełniając pola poniżej. Będziesz na bieżąco ze wszystkimi wydarzeniami związanymi z Silesia SEM i informacjami o marketingu internetowym w sieci. Nie spamujemy.

Zostanie wysłany do Ciebie e-mail potwierdzający: przeczytaj zawarte w nim instrukcje, aby potwierdzić subskrypcję.

Artur Strzelecki

Ostatnie wpisy Artur Strzelecki (zobacz wszystkie)

- Festiwal SEO 2025 Katowice - 28 marca 2025

- AI Overviews już w Polsce i Europie: Rewolucja w Wyszukiwaniu Google? - 26 marca 2025

- Czy wiadomości mają znaczenie dla Google? Wnioski z eksperymentu EU 2025 - 25 marca 2025

Dobra robota 🙂

Chciałbym wszystkich powitać w gronie białych rycerzy 😀

Niezły coming out 😛

Pikny zestaw do śniadania 🙂

@Paweł – boisz się konkurencji? 🙂

Dobry zestaw:)

Artur, jeszcze jedno takie zestawienie i można zrobić panel => nowy model szkoleń SEO, pt. „Rzeczy seo-trudne, wybierz sam w którą stronę pójdziesz..” 😉 …zapraszając wszystkich do Katowic 🙂

Świetna sprawa, będzie co poczytać 🙂 Fajnie, że organizujesz takie „zbiorowe” teksty, dobrze jest poznać zdanie wielu osób na dany temat.

Link do „Narzędzia dla Webmasterów” na dole wpisu nie działa.

Ciekawe informacje, sorry że nie znalazłem czasu na swoją wypowiedź…

Mega kompendium wiedzy o Disavow Tool!

Świetna robota Artur!

Btw. „Ostatni będą pierwszymi” 😉

No pinknie

Czyli nie ma się co martwić rośnie rynek dwóch specjalności: oferm bo jak się nie umie pozycjonować to teraz łatwiej depozycjonować oraz lekarzy toksykologii.

Bardzo fajne zestawienie!

Za biało.

Problem leży w ludziach – nie moje to wysyłam do disavow + brak zrozumienia działania narzędzia.

Nie mogę zgodzić ze Zgredem. Tyczy się linków w stopce od projektantów stron. Mam jedną stronę bardzo wysoko w Polsce, która ma 90%-95% (30-40 stron) linków site-wide w stopce. 10%-5% to jakieś profile zakładane na polskich i zagranicznych forach. Na forach zadawałem pytania wiec przy okazji linki wstawiałem. Jestem wyżej niż TOP-owe AGENCJE. Trochę wypadek przy pracy bo za bardzo na tej stronie się nie skupiam. Nie uważam że nofollow w stopce dla webmastera do dobra sprawa.

Znowu tasiemiec 🙂 Nie do śniadania, a do kilku 😉

Proszę o dołączenie jeszcze mojej porady: Nie śmieć, to nie będziesz musiał sprzątać 🙂

A ja dodam coś jeszcze od siebie – mimo że może to być dla wszystkich oczywiste, w praktyce różnie to wygląda.

W trakcie oczyszczania profilu linków, ostatnie co należy robić, to kontynuować pozyskiwanie linków w taki sam sposób, jaki doprowadził do filtra. Również po zdjęciu filtra nie należy wracać do starych metod – widziałam jeden taki przypadek, który po zdjęciu filtra dostał kolejny i nadal się z nim męczy.

Gratuluję przygotowania zestawienia. Chcąc-niechcąc wyszedł poradnik tylko dla osób które są dobrze obeznane z tematem SEO, a dla laików to wszystko brzmi jak czarna magia. A mogła to być bardziej przystępnie podana wiedza.

Dużo czytania ale także jak dużo nowych twarzy, woow

Bardzo ciekawy pomysł z Trust Ratio. Można się tym również kierować przy budowaniu profilu linków w danej branży dla zupełnie nowej strony. I tak właśnie polecimy! 🙂

Arcyciekawe:)

I znów jest co czytać. Dziękuję ekipie Silesiasem i autorom za masę informacji.

Przepraszam Artur, że nie dosłałem materiału. Cały czas bardzo ciężko pracuję nad SiteCondition, rownież po nocach ;). Z drugiej strony wygląda na to, że wszystko zostało napisane 😀 Brawo Artur za inicjatywę, brawo wszyscy autorzy za chęć dzielenia się wiedzą. Podstawą jest wycofanie złych linków i spingowanie tych miejscówek a potem puszczenie wniosku o ponowne rozpatrzenie. To lepsze niż disavow. Warto też zupełnie już odstawić narzędzia do automatycznego katalogowania i preclowania – one dziś bardziej pchają w dół niż w górę. Pozdrawiam wszystkich.

Dobra robota. Dużo pomocnych informacji… jak sami mamy się tym disavow … wykończyć 🙂 …

Pogratulować! Tylko czekać teraz jak wszystkie gimbusy zaczną korzystać z Disavow – nie zdajecie sobie nawet sprawy jak sami niszczycie nasz rynek… ostatni gasi światło, powodzenia

Kolejne już tego typu zestawienie, co bardzo cieszy. Oby tak dalej.

„dla laików to wszystko brzmi jak czarna magia. A mogła to być bardziej przystępnie podana wiedza.”

Tylko co laik zrobiłby z taką wiedzą, skoro nie powinien samodzielnie próbować takich działań?

Bardzo ciekawy zbiór 😉 Niezła robota! Gratulacje.

Bardzo fajny artykuł, kawa mi się skończyła a ja dalej czytałem i czytałem 🙂 Martwi mnie jednak to, że za lekko napisane jest o disavow tool. Jeżeli początkujący pozycjoner nie przeczyta dokładnie to zaraz będzie wrzucał linki jak leci. Co prawda kilka osób pisało o nie nadużywaniu tego narzędzia, ale fajnie by było jakby ktoś opisał tego działanie. Mimo to artykuł bardzo fajny. Dla sportu można „przeskanować” linki dla stron, co na pewno pozwoli/pomoże uniknąć nieprzyjemności z google

Dobra robota – wniosek jeden – żadnych wniosków 😉 Nie ma 100% recepty na sukces 😉

Jeden temat kilka opinii, doskonałe zestawienie. Dziękuję.

Mega robota Panie i Panowie

@Filip z volt-room:

moje wskazówki są ogólnikowe, niestety nie da się w sposób prosty obrobić tematu o którym mówisz. Widocznie jeszcze nie dostałeś kary więc cierpliwie poczekam rok/dwa aż ja dostaniesz 😛

Porady bardzo dobre (fakt, w niektórych momentach bardzo ogólne) ale pozwalają na wypracowanie własnej metody zdejmowania filtrów ze stron internetowych. Podstawy są, resztę trzeba dopracować już praktyką. 🙂 P.S. Również uważam, że trzeba bardzo ostrożnie używać Disavow Tool.

Jakie widzicie szanse na powrót do top10 po zdjęciu kary ?

A co myślicie o swlach w których dodajemy jedynie brand i url? Ja to zostawiam

Nigdy nie używałem SWL – lepiej tę pieniądze zainwestować w stworzenie zaplecza dla klienta. Jeśli ktoś się zastanawia czy warto to Marta pomoże rozwiać wszelkie wątpliwości: http://www.lexy.com.pl/blog/kiedy-warto-inwestowac-we-wlasne-zaplecze.html.

Zgadzam się też z Filipem na temat linków site-wide. Różnie to bywa i wiele zależy od czynników on-site i off-site strony, na której został umieszczony. Jeśli strona będzie typowym spamem to nic jej nie pomoże i lepiej pozbyć się linka z takiej domeny, ponieważ może się to zemścić w przyszłości. Jeśli zaś strona będzie wartościowa (linki, treść itp.) to nawet nietematyczny link nie powinien zaszkodzić:) Jednak jak to zwykle w przypadku google od tej zasady są zawsze wyjątki.

Świetne zestawienie jak zawsze 🙂 Czytam zawsze od deski do deski i próbuję wyciągnąć kilka pożytecznych porad. Thx i pozdrawiam

Gratuluję wszystkim, porządnie zrobionego zestawienia. Bardzo fajnie, że w jednym miejscu czytelnicy mogą znaleźć tyle przydatnych informacji. We wpisie można przeczytać wiele porad dotyczących oczyszczania profilu linków. Ja chciałbym zwrócić tylko uwagę na to, że warto trochę się potrudzić i zainwestować w dobrej jakości linki pochodzące z różnych źródeł, domen, adresów IP etc. Przy ich wyborze nie powinniśmy się tylko kierować wartością PageRank, lecz również Page Authority, Domain Authority, Trust Flow, Citation Flow i innymi parametrami. Proponuję potraktować stronę tak, jak by była żywym organizmem, który reaguje w zależności od tego co zje. Jeśli zaaplikujemy jej śmieciowe odnośniki, to może to skończyć się jej chorobą (filtrem, spadkiem w wynikach, a nawet wyindeksowaniem). W pierwszej kolejności warto zastosować środki zapobiegawcze (linkować tylko z wartościowych stron), niż później być zmuszonym zapłacić specjaliście za usunięcie odnośników szkodzących stronie.

@Maciej, jak już mówimy o oczyszczaniu linków, to właśnie dokładnie „przemaglowałem” SEO Odkurzacza – pomęczyłem go mocno, wart jest swojej ceny 🙂 – http://blog.seo-profi.pl/seo-odkurzacz-swietne-narzedzie-do-analizy-linkow-przychodzacych/

Potrzebna pomoc!

Około 2 miesiące temu kupiłem domenę. Sam próbuje ją pozycjonować ze względu na dość duże koszty z tym związane.. Okazało się że domena którą zakupiłem ma kilkanasie tysięcy backlinków po sprawdzeniu w narzędziach (majestic, seospyGlass) chciałbym się ich pozbyć ale zdobyłem kilkanaście wartościowych linków które chciałbym zatrzymać. Podstrony nie są indeksowana przez google, tylko strona główna a pozycja strony nie jest nawet w pierwszej 50! i nie zmienia się to od miesiąca! w webmasters tools mam listę tych linków które sam zdobyłem i nie chciałbym się ich pozbywać.. co mam zrobić w takiej sytuacji?

Mam podstronę z profilami użytkowników, część z nich jest linkowana dopalaczami, jeśli zablokuję profil i wyświetlę 404 (nie zmieniam adresu, tylko daję nagłówek 404) i wczytuję specjalną stronę to powinna ona linkować do strony głównej portalu?

Fajny tekst, pomógł 🙂