Raport Analityka wyszukiwania w Google Search Console udostępnia do 1000 wierszy z danymi. Dostęp za pośrednictwem tego connectora pozwala wyciągnąć do 5000 wierszy i dowolnie konfigurować zbiór otrzymanych danych.

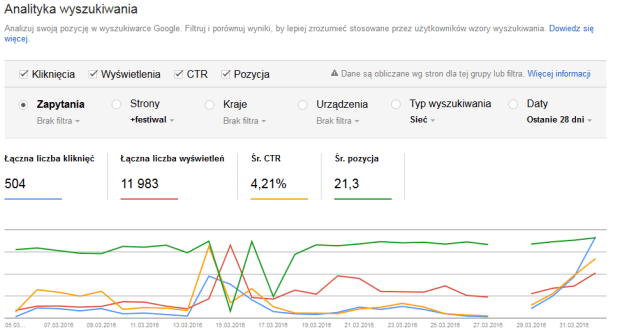

Analityka internetowa to raport, który dostarcza wielu cennych danych właścicielowi strony internetowej. Dla małych stron bardzo dobrze spełnia on swoje funkcje. Niestety jego ograniczenie to tylko 1000 wierszy. Ponadto dodawanie lub usuwanie wymiarów, zmiany w typach wyszukiwaniach, krajach i pozostałych opcjach nie są na tyle elastyczne, jak mogłyby być.

Google w zeszłym roku wprowadził API dla Search Console, które pozwala pobierać dane. Na początku możliwości były ograniczone, ale ostatnio wprowadzono nowe metody, które niezwykle ułatwiły i przyspieszyły pracę z danymi.

Można ręcznie spróbować jak działa pobieranie danych po API. Metoda wyciągnięcia danych została opisana na blogu Bluerank a wykorzystywana jest opcja “Try It!”

Do profesjonalnego zastosowania taka manufaktura jest niewystarczająca. Niszę, która pojawiła się w tym zakresie fantastycznie wykorzystał Clusteric Search Auditor (przeczytaj pełną recenzję). Do programu w sekcji narzędzia został dodany moduł, który korzystając z wyżej wymienionego API pobiera dane z Search Console.

Do 17 kwietnia 2016 skorzystaj z kuponu 30% “SilesiaSEM” i zakup Clusteric Search Auditor.

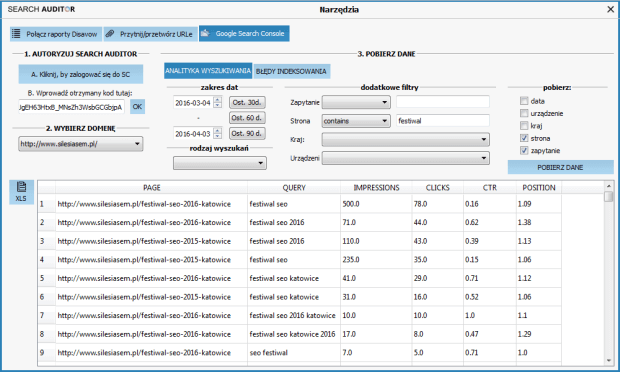

Po autoryzacji API wystarczy wybrać domenę dla której chcemy pobrać dane i zaznaczyć interesujące nas wymiary i wartości. W ułamku sekundy dane zostaną pobrane i wyświetlone w oknie programu. Pobierany zbiór danych można dowolnie konfigurować i zapisywać w przedziałach czasowych do pliku w XLS.

Zalety nowego modułu do pobierania danych z Search Console:

- Maksymalnie 5000 wierszy

- Łatwa konfiguracja zestawu danych

- Szybkie zapisywanie do pliku XLS w celu archiwizowania zbiorów

- Dodanie wymiaru DATA pozwala bardzo szczegółowo analizować dane

Zobacz export danych z Search Console z wykorzystaniem API

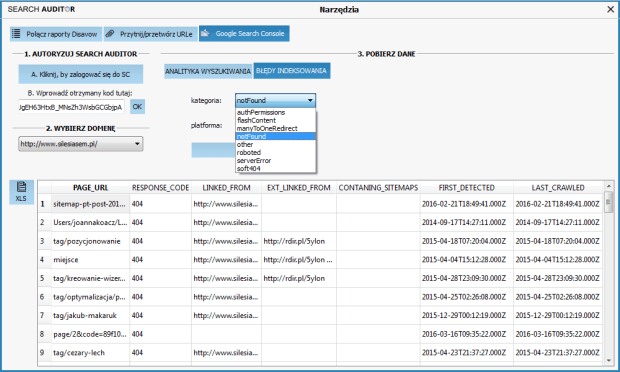

To API również udostępnia dostęp do raportu Błędy indeksowania. Można podejrzeć pełną informację o błędach indeksowania, ich przyczynie wynikającej z błędnej sitemapy lub linku zewnętrznego bez potrzeby przeklikiwania się przez ten raport w tradycyjnym interfejsie Search Console.

Zakup Clusteric Search Auditor. Z kodem „SilesiaSEM” 30% taniej.

http://clusteric.com/pl/link-auditor-zakup/

Artur Strzelecki

Ostatnie wpisy Artur Strzelecki (zobacz wszystkie)

- Festiwal SEO 2025 Katowice - 28 marca 2025

- AI Overviews już w Polsce i Europie: Rewolucja w Wyszukiwaniu Google? - 26 marca 2025

- Czy wiadomości mają znaczenie dla Google? Wnioski z eksperymentu EU 2025 - 25 marca 2025

Clusteric może i dobry program, licencja dożywotnia, ale update’y tylko przez pół roku. Przy złym wietrze takie narzędzie może się bardzo szybko zdezaktualizować

@Krzysiek:

Długo myśleliśmy nad modelem sprzedaży licencji.

Aktualizacje są za darmo przez pół roku, potem płatne. Jeśli ktoś nie potrzebuje danych z naszego API, to same przedłużenia aktualizacji są naprawdę tanie – zaczynają się od… 35zł za pół roku (a na rok jest jeszcze dodatkowa zniżka).

W oparciu o doświadczenia z poprzednimi narzędziami i obserwując inne programy i ich cykl życia dochodzę do wniosku, że model z całkowicie bezpłatnymi aktualizacjami jest zły. Programy mają swój cykl życia i bywa, że po początkowym okresie „boomu” sprzedaż nowych licencji spada, ale program wciąż ma wielu aktywnych użytkowników. Brak płatnych aktualizacji w takiej sytuacji spowoduje, że rozwój nieabonamentowego narzędzia zwyczajnie stanie – poza pewnymi wyjątkami. To zwykła konfrontacja oczekiwań i przyjętych początkowo założeń z rzeczywistością. Autor aplikacji bez opłat za aktualizacje zwyczajnie zacznie pracę nad innymi projektami (które też wymagają poświęcenia wiele czasu, by doprowadzić je do etapu, gdy można je wprowadzić na rynek; być może też część z nich okaże się nietrafiona).

Dlaczego nie dajemy dożywotnich aktualizacji?

Staramy się podążać za aktualnymi trendami, budujemy też API, z którego chcemy podawać użytkownikom jak najatrakcyjniejsze dane. To wiąże się ze stałymi kosztami (przede wszystkim serwery gromadzące, agregujące i podające dane). Płatność za późniejsze aktualizacje i podawane przez nas dane pozwala planować rozwój (a koszty są rosnące gdy chcemy zwiększać zakres i zasięg; nie mówiąc już o inwestycji w ludzi, którzy pracują przy projektach).

Dzięki temu, że zbieramy więcej danych na własną rękę, łatwiej też jest zapewnić, że oprogramowanie będzie użyteczne w dłuższej perspektywie czasowej. Uniezależniamy się w ten sposób od rozwiązań, na które nie mamy wpływu (weźmy za przykład nieaktualizowany od dawna Page Rank, który kiedyś był jednym z ważniejszych wskaźników,a teraz odchodzi w niepamięć) w zamian oferując nasze własne.

Mówiąc szczerze, myślę, że abonament za aktualizacje lepiej sprawdza się w praktyce. Pozwala na planowanie rozwoju na kolejne miesiące/lata i tworzenie dopracowanych, rozbudowanych narzędzi, które odpowiadają faktycznym potrzebom użytkowników. Zwłaszcza tych, którzy już je dobrze poznali i którzy wiedzą, czego im brakuje. Cykl życia softów bez żadnego abonamentu zwykle pokazuje, że użytkownik i tak często „zapłaci abonament”. Po prostu dostanie trzy jako-takie softy zamiast jednego rozwijanego albo „dużą, nową wersję” zamiast mniejszych aktualizacji.

Myślę, że uczciwiej jest podać ceny aktualizacji i powiedzieć „jeśli będziesz zadowolony, przedłuż”. Mamy wtedy do czynienia z jasnymi motywacjami z obu stron.

Trochę się rozpisałem, ale tak to wygląda w oparciu o moje doświadczenia i obserwacje rynku softów – zwłaszcza tych niszowych. Myślę, że wiele osób podziela ten punkt widzenia.

Pozdrawiam,

Damian Kiełbasa

@Damian

Kwestia kosztów to jedno. Nie lepiej dla wszystkich byłoby po prostu użyć modelu SaaS? Dla klientów byłoby to łatwiej budżetować (w niektórych firmach wydanie $30 trwa tak samo długo co wydanie $30k), enduserzy nie muszą się martwić aktualizacjami, wy macie sprawny model biznesowy przynoszący regularne przychody (a nie tylko za aktualizacje). Może jest to coś wartego zastanowienia. Macie API, więc rozumiem że wymagałoby to stworzenia interfejsu webowego.

Druga sprawa to jako osoba, która zajmuje się głównie analizą danych zawsze największym problemem są pofragmentowane dane, silosy i inne części składowe pochowane w różnych miejscach. Z tej perspektywy tworzenie desktopowego programu z opcją API jest dla mnie niezrozumiałe. Duże bardziej sensowne w dzisiejszych czasach wydaje mi się właśnie webowy interfejs z wykorzystaniem API. Można się dalej zastanawiać, czy budować integracje z innymi narzędziami. Kiedy patrzę na rozwiązania takie, jak Searchmetrics czy np. Brightedge – tam nie ma żadnych fenomenalnych i cudownych rozwiązań. Dane są takie same jak u wszystkich. Różnica jest w tym jak one są oferowane i jak dalece są przerobione.

Na pewno się nie zgodzę, że soft do SEO to sprawa niszowa, ale ostatecznie to wy decydujecie, w którą stronę chcecie iść. Może inna perspektywa też się przyda 😉

Pozdrawiam, Krzysiek

@Krzysiek: Serdeczne dzięki za podzielenie się spojrzeniem. 🙂

W zdecydowanej większości zgadzam się z tym, co napisałeś. My też widzimy wiele zalet SaaS. Obecne rozwiązanie wynika w dużej mierze z tego, że zaczynaliśmy jako aplikacja do audytu profilu linków, której użytkownik zbierał dużą część danych we własnym zakresie (co pozwala też oferować program w niewygórowanej cenie). W ostatnich miesiącach bardzo mocno rozbudowaliśmy stronę serwerową – między innymi uruchomiliśmy API statystyk społecznościowych, rozwijamy indeks backlinków, analizę widoczności.

Zwłaszcza jeśli chodzi o te ostatnie, pokazanie danych w webowym interfejsie wydaje się być bardzo naturalne i prawdopodobnie po udoskonaleniu powyższych będziemy chcieli dać użytkownikom taki dostęp.

Pozdrawiam,

Damian